围剿英伟达:深度揭秘深氪产业链!

访谈|邱晓芬 杨逍

编辑|苏建勋 杨轩

反抗一个隐秘的微信群,在上海张江的AI芯片公司人士中口口相传,群名叫“国产芯片抱团取暖群”,进群的必须是国产芯片公司员工,在这里,即使是竞争对手,也会交换信息,互换商务资源。

“国产芯片抱团取暖群”圈定了一块停战区,同行可以暂时休战,互帮互助,只因为大家都有一个共同的敌人:英伟达。

因为英伟达的存在,国产芯片公司的销售,多少都尝过一点屈辱的滋味。

李明(化名)是一家国产GPU公司的销售,这一轮AI热潮掀起时,他曾信心满满地去见客户,可来不及寒暄,客户开口就是连环追问:

“你们的东西,和英伟达A100芯片相比,啥差距?英伟达有NVLink,你们有什么?”(作者注:NVLink是把多个GPU芯片连接起来,避免GPU的数据搬到CPU计算,以提升计算效率)

眼见用产品和技术打动不了客户,李明的团队开始想办法托关系,找“更有力的人士”去游说,但客户还是摆摆手,“我们还是想用英伟达”。

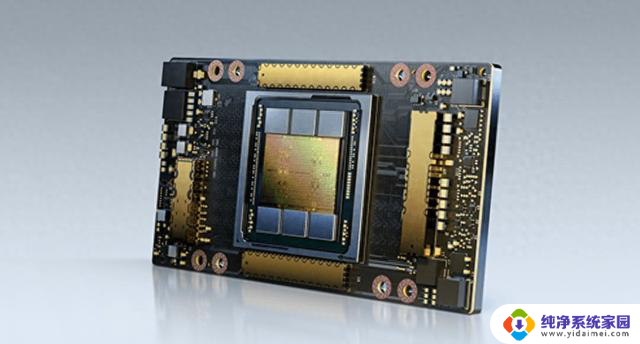

英伟达A100,826平方毫米的面积上,塞了540亿个晶体管,是打开AI大模型魔盒的钥匙。

大模型训练,像是在海量数据中“炼丹”,目的是找出数据变化的规律;而用英伟达芯片训练大模型,就好比让几亿个智商200的人来算数,而其它芯片的效果,只等同于找了几千个智商100的人来计算。

英伟达A100 图片来自英伟达官网

最顶尖的科技公司,都在疯狂抢购英伟达。谁拥有最多的英伟达高端GPU,谁就有机会训练出更聪明的大模型。

公开信息显示,OpenAI目前掌握着全世界最多的英伟达高端GPU,至少达五万片;谷歌、Meta也是万卡集群的拥有者(2.6万左右);而国内罕见有英伟达高端GPU万卡集群的互联网大厂,是字节跳动(1.3万)。

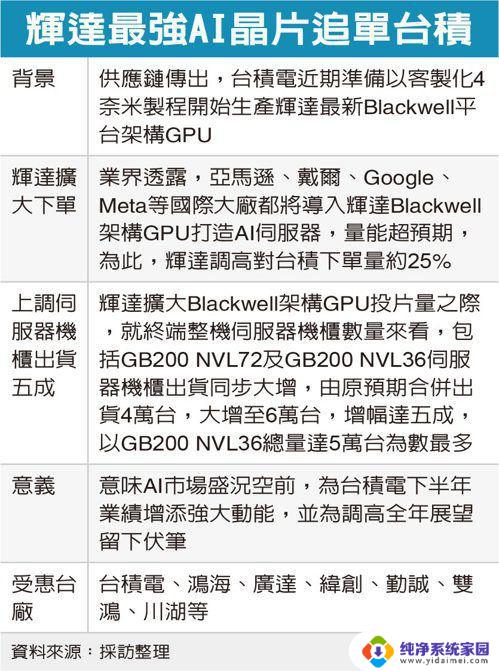

英伟达垄断着全球产业链上最好的资源——拥有台积电最充足的芯片先进制程产能、笼络着全世界最大的工程师用户群体,掌握了一众AI公司的计算命脉。

绝对的垄断,往往会滋生不满、愤怒和逃离。

“今天所有做大模型的,基本都在严重亏钱!只有一家在赚钱!英伟达”,一位行业人士语气忿忿不平——“英伟达的利润率让所有的客户都很难受,很伤害AI行业!”。

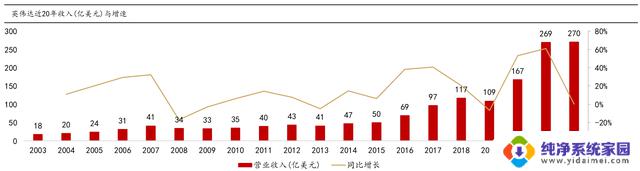

财报显示,英伟达毛利率达到71%,其中,热门产品A100和H100系列,毛利率高达90%。作为一家硬件公司,英伟达居然享有比互联网软件公司更高的毛利率。

高价暴利,让英伟达的大客户开始逃离。7月30日,苹果宣布其AI模型用8000片谷歌TPU来训练,而英伟达含量是0;消息一出,7月31日,英伟达股价下跌超7%,创下近三个月最大跌幅,市值蒸发1930亿美元,几乎跌掉了一个拼多多。

英伟达最近一年股价跌幅图

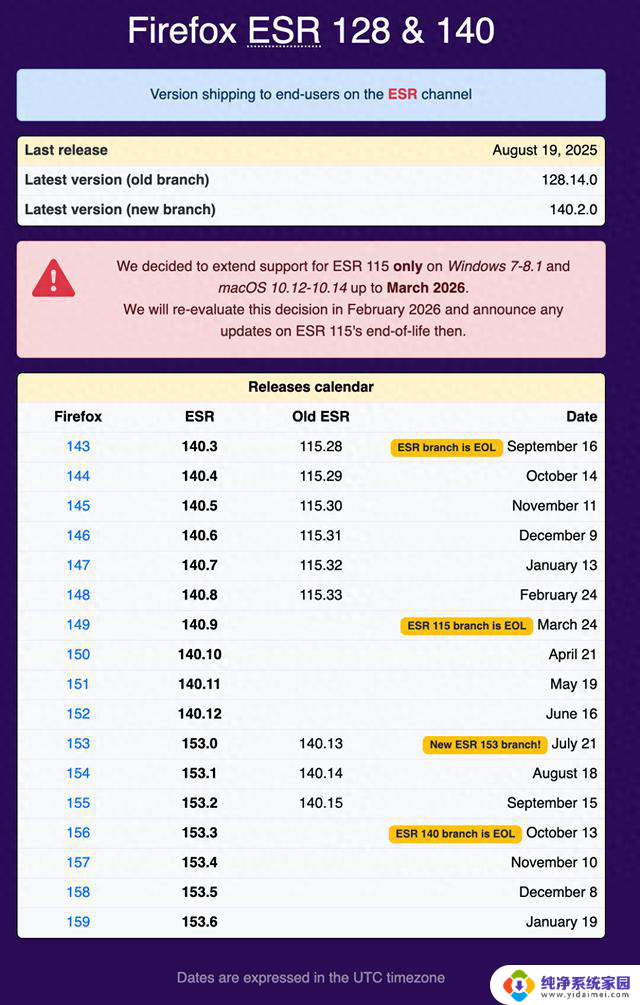

对于所有想在英伟达身上撕下一块肉的国内GPU企业来说,2022年是个转机之年。美国数轮禁令下达,英伟达迫于生计,在中国持续推出阉割版本芯片,但又被快速禁用:

2022年9月,A100/H00禁止向中国出口,英伟达推出阉割版本A800/H800;2023年10月,A800/H800/L40/L40S/RTX4090被禁止向中国出口;

2024年6月,英伟达创始人黄仁勋称,将向中国推送阉割版本的L20、H20芯片。

然而,阉割版本引发了行业更激烈的声讨。英伟达即将推送的H20,价格虽是英伟达H100的一半,性能却前者只有1/3。一位AI行业人士怒斥——“这不就抢钱吗?纯纯智商税!”

当英伟达的客户开始不满与愤怒,那些想代替英伟达的国产芯片公司,却在这种情绪中得到了“滋养”。

过去,他们只能跟在英伟达的屁股后面,艰难分食一点点蛋糕碎屑。半导体分析公司TechInsights的一项数据显示, 2023年,英伟达在数据中心GPU出货量市场份额高达98%,国产芯片和一众芯片巨头加起来,只占微弱的2%。

如今禁令袭来,完美的英伟达在中国市场被撕开一道口子,谁能替代英伟达?国产AI芯片厂商看到了生机。

“今年咔嚓,英伟达在中国的90%市场都给释放出来了,能不能抢到,各凭本事”,一家国产GPU公司创始人表示。

36氪曾在2021年发表过《深氪|宁德时代:万亿电池帝国的裂缝》,在动力电池行业,宁德时代一骑绝尘,被竞争对手们虎视眈眈。

如今,在AI芯片领域一家独大的英伟达,也被诸多同行视为眼中钉、肉中刺,但英伟达的不同在于,它的壁垒更高,与对手们的差距更大。

我们尝试通过英伟达对手们的反抗,去找到“英伟达的裂缝”,放眼GPU行业,国产GPU、AI芯片厂商虽然力量孱弱,但他们更懂中国市场,打法更加本土化;而诸如英特尔、AMD等老牌芯片巨头,则有着更充足的粮草弹药,正面对击英伟达。

短期内,英伟达不会被打倒,但它也不会毫发无伤,这注定是一场血腥的战争。

突围想突围,就要找到对手的弱点。英伟达的弱点之一是:傲慢。

芯片行业,本质上是一个To B软件行业。客户需要芯片厂商“陪伴感”的服务,比如把硬件调试好、把软硬件兼容做好,陪伴到位了,客户才有粘性,芯片产品就不容易被替换。

但多位国产芯片人士告诉36氪,在中国市场,除了像BAT、字节这样几十亿规模的大采购方,其余大部分公司交易额纵使达几千万,几乎很难得到来自英伟达的售后服务。

也就是说,当使用英伟达芯片的中国工程师们有疑惑时,只能靠自己到英伟达官网上搜索文档,或者去社区自学。

和英伟达合作时,中国客户们的种种需求经常得不到满足。一位芯片行业人士告诉36氪,英伟达在中国一般会推最高配、最贵的全套方案,而当客户提出针对特定场景的定制化要求时,也一般会被否掉,客户们买完卡后,要“自己琢磨,或者再找厉害的算法公司搞定”。

英伟达的这种做法,积累了不少中小客户的抱怨。“英伟达如今作为大厂,对小客户已经不会像过去那样重视,他们的产品没有挑战者,不需要去费力讨好客户”,前述人士表示。

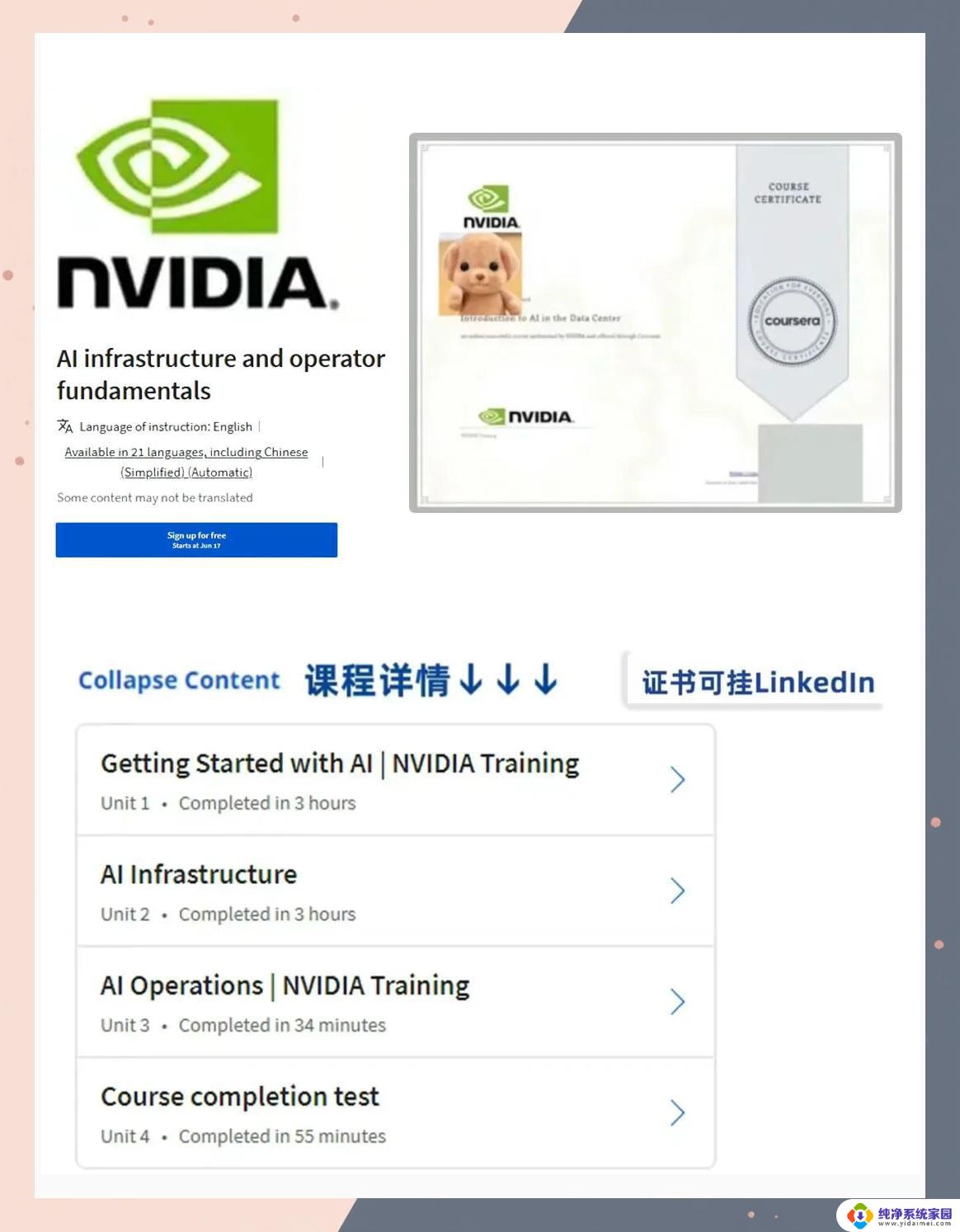

但在过去,英伟达生态的崛起其实印证了服务对于芯片行业的重要性:2006年,CUDA生态刚起步时,英伟达产品和如今的国产芯片一样并不出色。但英伟达团队先从高校的科研团队推起,再渗透到每一个细分行业的初创公司做软硬件适配,才有了如今的大片江山。

NVIDIA H100 图源:英伟达官网

中国芯片厂商们,也领悟到这一点,尝试从客户服务开始切入。

国内某家不愿具名的AI芯片公司,2023年以来,尝试让后台的研发人员走到一线亲自服务——不仅要驻场联合调教,在销售打单后,给客户专门拉个有研发人员的小群。客单价小到几百万、几十万不等,都能享受7×24小时的咨询。

光提供本地化的贴心服务远远不够,在英伟达中国大撤退之余,芯片行业而早已不简单是芯片产品本身对决,更考验着各自对时间窗口期的把握。中国芯片厂商就像一群狼扑上来,轰轰烈烈的打单开始了。

华为来势最凶猛。华为此前联合讯飞,发布的设备「星火一体机」上,就搭载了「昇腾910B」。

这颗芯片,曾号称单卡能力“对标英伟达A100”。不为人知的是,光鲜案例背后艰难的一面——36氪了解到,华为对此不惜人力成本,调配了几百名工程师下场帮讯飞调教参数。

华为和讯飞发布星火一体机,图源讯飞

尽管这被行业称为“手工打造”,但标杆案例一出,许多大模型公司、互联网公司都对华为抛出了测试的橄榄枝。

一家国产芯片销售惊讶发现,自从去年7月份至今,只要是公开招标的智能算力中心项目,都能看到华为级别不低的管理层在那驻场,“华为如今一个项目可以派几百个人上去服务,甚至一些关键项目不惜亏本,从别的项目获得收入”。

前述不具名芯片公司,也配齐了200名铁血销售——在国内芯片行业,这都是一个相当罕见的配置。他们的销售团队从大模型落地最火热的三个领域开始入手,金融、法律、工业,几乎出现在每一场与算力相关的展会, “芯片行业,资源第一,跑的慢了就死掉了”。

国产芯片一场隐秘的价格战也开始了。

一位芯片行业人士告诉36氪,他们的目标是,不惜单价,也要拿下更多标杆智能算力中心的单子。36 氪观察到,有的国产公司推理卡,为了降低成本,不惜把价贵的HBM(高带宽内存)拿掉,甚至以低于成本价50%的价格在出货。

“不管怎么样,大家还是希望从各个切入点突破,各自从英伟达那切走一小小块蛋糕,让英伟达不再是一家独大”。

但现实却是残酷的,具体到产品上,国产AI芯片难免出现种种问题。

一位芯片人士向36氪举例:同样处理一个数据集,用英伟达的A100集群来跑,可能只需要十天,但用某些国产芯片产品,可能要跑上好几个月。国产芯片硬件上积累的时间太短,又缺先进制程,硬件上的差距,导致使用效率不高。

软件短板也很明显。另一位行业人士测试发现,当使用国产芯片跑大模型时,若要在上面做更多酷炫应用,基础大模型做一旦改动,国产芯片就容易发生死机,“很多情况下,国产芯片大家基本是捏着鼻子用起来”。

如今,各家真正看清了眼前的“围剿”策略,也逐渐分化出了更现实的路径:

尽管还有少数派继续往万卡集群进发,着重训练场景,和英伟达硬刚,其中以摩尔线程、华为为代表;但更多数派的选择是,转而更关注大模型/小模型在各行各业的落地,从对硬件、软件要求都不高的推理场景抓起,以燧原、天数智芯等为代表。

(36氪注:大模型有训练和推理两个环节:训练是从几十亿数据库中寻找规律的过程,是“造”大模型;推理是在“用”大模型的过程,难度更小、对软硬件要求更低、与产业连接更紧密)

摩尔线程在2024年人工智能大会上发布夸娥万卡集群 36氪拍摄

“我们如今没有盲目追赶英伟达,我们追不起,不敢盲目做超大算力的芯片”,一位芯片行业人士直言。

国内芯片厂商们一个现实的考量是,英伟达的主要精力并不在此,国内厂商为此避开了英伟达的正面战火。

此前,大部分公司基于成本考虑,多采用英伟达消费级游戏显卡4090来跑推理——这些卡的问题一堆:功耗过高、内存不够、被禁用。英伟达官方也不允许这些消费级显卡被用于大模型推理。

国产芯片公司从英伟达这一空白处切入。天数智芯、燧原今年都在猛推对标4090的推理卡,打出了大内存、低功耗、供应稳定的卖点。

国产芯片厂商也明确了找准细分市场的重要性。比如则针对一些功耗敏感的场景,主打低功耗小芯片;或者扎进视频优化等细分场景,做小而美的生意。

巨头战场,剑拔弩张当国产GPU公司将“超越英伟达”写进PPT,这更像一种美好的愿景,这群公司成立时间不长,迎上了国产替代的风口,即便只超越一点,也被视作是壮举,英伟达之于他们,是对手,也是标杆。

但论及与英伟达辈分相当的英特尔、AMD,气氛就更加剑拔弩张。

“我们内部将英伟达当作死敌”,AMD的一位MI系列产品线的研发人员告诉36氪。

在今年6月的台北电脑展(Computex 2024)上,AMD创始人苏姿丰(她还是英伟达创始人黄仁勋的表亲)也首次明确了未来AMD在GPU上的产品节奏——每年迭代一款新的GPU产品,和英伟达更新节奏保持一致。

英伟达几乎每上一款GPU,AMD都会第一时间从市场上买回来拆机,与还没上市的产品做对比。

“这里要加点feature(指标)、那里参数要拉高”,他们追求的是,“硬件上不能落后于英伟达,参数上微赢”,前述人士对36氪提到。

苏姿丰在今年台北电脑展上发布Instinct MI325X

2023年以来,AMD中国生态合作伙伴们,几乎每隔两天,就会收到来自AMD的软件优化新诉求。为了推广他们的GPU,AMD高管们有时还会要求更优势的CPU部门,搭配着GPU去打单,顶着CPU可能卖不出去的风险。

“AMD的人天天‘烧香拜佛’,就希望我们把生态搞起来”,一家生态公司高管表示,据他透露,目前国内已经有10多家云厂商和To B客户,在和AMD芯片相关的适配和效果验证。

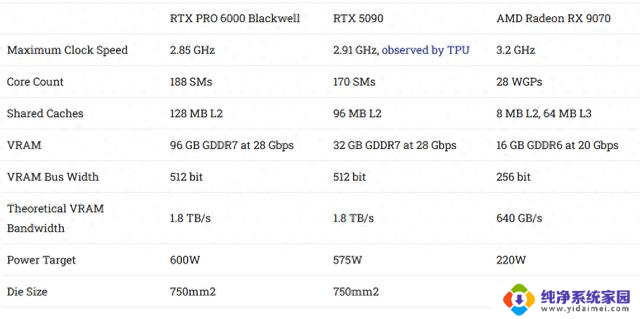

相比于一众焦灼的国产芯片厂商,国外芯片巨头们在硬件层面的优势在于,拥有先进制程和HBM产能,因此,AMD、英特尔的产品,相比于英伟达产品其实不会有太大的差距,某种程度上甚至更优异。

官方的数据显示,AMD的产品(2023年12月发布的MI300X)此前宣称算力是英伟达H100的1.2倍;

英特尔的产品(2024年4月发布的Gaudi 3)在能效和推理性能上也远超H100。当然,也更便宜,AMD的GPU价格大概是英伟达对标产品的七八成。

但所有和英伟达正面硬刚的厂商都面临着一个共同的难题:大家的硬件如何有优势,都因软件劣势而黯淡,如同木桶的短板。

在GPU还只能用于图形计算的年代,英伟达推出的软件平台CUDA,相当于给开发者提供了一套编程接口,让他们能最熟悉的编程语言,在GPU上自如编写计算程序。

“我给你们打个比方,CUDA为什么超越不了,就好比你学会一种语言,这么多年,都是用这个语言干活的,如果我让你换一套语言,你会不会很难受,会不会不愿意?”一家芯片公司员工这样给36氪举例。

CUDA作为英伟达软件生态壁垒最深厚之处,纵是家大业大的英特尔、AMD也无法短时间内弯道超车。

一位英特尔GPU团队前员工告诉36氪,他们曾经安排全球3000多名工程师、投入了三四年,却只把精度从0%提升到4%——他们用英特尔的芯片转换一张人像,等待许久,信息丢失到“已看不出是一张人脸”。

英特尔CEO基辛格发布Gaudi系列芯片

“鸡生蛋还是蛋生鸡”的谬论再现。正是由于AMD和英特尔的GPU用的人不多,其及对应的软件平台(ROCm、oneAPI)用的人也更少,因此很难有人能把它们真正的硬件能力完全发挥出来。

“英伟达的CUDA一直有那么多开发者在上面迭代算法,帮英伟达把推理和训练做得很高效。导致英伟达一直能有议价权,他也永远知道他下一个芯片应该咋做,但这是AMD和英特尔都很头疼的事”,一家AMD生态公司CEO直言,如今AMD的软件工具ROCm,“就像20年前的英伟达CUDA一般”。

但对于下游客户来说,风险正是由此而生。

验证大模型本就是一项有不确定性的实验,若还要在一个没有被验证过的芯片上跑,相当于把两个不可控的变量放在一起——抛弃英伟达,意味着要支付巨大迁移成本,承载不确定性。

尽管如此,围剿英伟达,对于AMD和英特尔这两家来说,依旧是一场不得不打的仗。

全球芯片架构三分天下:X86架构指导着PC领域,是英特尔和AMD的天下;移动市场是Arm的天下;英伟达则主导着人工智能市场。

在全新AI革命引领时代的近一年半,英伟达一度跨过3万亿美金市值大关,如今也相当于7个英特尔+AMD市值的总和。

时隔20年后,芯片巨头们对英伟达的「围剿」,是又一场焦灼的战事,这也是一场后知后觉的反扑。

真正的裂缝当国内AI芯片公司组成蚂蚁雄兵,AMD和英特尔全力以赴,遭遇此等围追堵截的英伟达,真的被撼动了吗?

英伟达帝国的裂缝,正在悄悄蔓延。

一个让英伟达必须警惕的信号是,OpenAI、谷歌、微软……这些因AI信仰,为英伟达充值的大客户们,正迈出“反英伟达”第一步。

自研芯片是各家筹谋已久的棋局。一位谷歌TPU团队的前核心员工告诉36氪,用掉了世界上1/4算力的谷歌,“可能年底就不对外采购芯片了”。

过去谷歌自研TPU更多基于成本考虑,比如担心英伟达随意涨价,或者供应不够稳定,如今谷歌的造芯策略更为激进——“几乎是不计代价和成本投入”。

OpenAI则有无数手准备,他们计划筹资高达7万亿美元,建立一个全新的AI芯片帝国。

在国内,36氪也从多方了解到——目前英伟达在国内最大的买方,阿里、字节、百度,基本都在秘密研究用于大模型训练的芯片。

海外云厂商、大模型厂商、明星芯片厂商产品进展,36 氪综合信息整理、制图

不过,自研芯片毕竟是一个长远之计,这些大客户们短期内的另一项方案是,尝试英伟达对手们的产品,减少对英伟达的依赖。

AMD就是这个Plan B。一位AMD内部人士告诉36氪,AMD的GPU产品已经在欧洲、美国、韩国等地,打开了大客户市场——微软已经采购上万片AMD的产品,特斯拉、Midjourney、美国国家实验室、韩国电信也都已批量提货。

在国内,AMD生态公司员工陈文表示,AMD某型号加速卡在2023年有几百片出货,虽不多,“但AMD的这款产品,此前在国内几乎查无此人”。

根据AMD方面此前乐观预计,在2024年年底,数据中心GPU将给AMD带来高达20亿美元的收入。

而中国芯片厂商的蚂蚁雄兵,虽然尚未对英伟达造成实质性威胁,但星星之火,也有渐起之势。

36氪了解到,如今,国产训练、推理芯片的销售,已经跃进了一个新台阶——一个令人欣慰的积极信号是,国内公认最难打单的互联网公司、大模型公司,已对国产芯片厂商开了口子。

据36氪了解,目前,昇腾芯片已经艰难突围进百度在内的互联网公司体系。

此外,国内诸如智谱AI、MiniMax、阶跃星辰等AI公司,都在训练万亿参数规模的大模型,但在英伟达高端芯片有限的情况下,大模型公司们普遍选择“混训”(即英伟达+其他芯片),比如,智谱AI的集群储备了近半的昇腾芯片。

另外,天数智芯、燧原的推理芯片产品去年以来,双双有了数万片的出货,出货渠道包括国内各大智算中心,前者打进了大模型厂商百川的供应链;百度昆仑芯这边,过去两代推理芯片累计出货量3-5万片,来自百度和外部渠道的出货量已各占一半。

“英伟达现在的价格和供应水位,正处于试探大家干不干、怎么干的边界线上”,一位行业人士直言。

英伟达创始人黄仁勋 图源视觉中国

如果把眼光拉得更到未来三五年,英伟达新的威胁也在逐渐闪现。

行业里面也出现了GPU之外的全新的AI芯片架构——比如此前推出LPU架构的硅谷芯片公司Groq,号称运行大语言模型比英伟达的GPU“速度快了十倍”;

还有发布了大模型ASIC芯片的硅谷芯片Etched,号称比英伟达GPU“快了一个数量级”。这些芯片创业公司,背后站着OpenAI这样的明星投资阵容。

36氪了解到,国内今年以来也冒出了全新的AI芯片创业公司。比如,上海市近来秘密支持了两家全新的AI芯片公司。

一家国产TPU公司「中昊芯英」CEO杨龚轶凡表示,GPU的整体晶体管利用率只有20%。其实缺陷很明显,相比之下,TPU和ASIC等新的架构虽然通用性不强,但晶体管利用率能够达到60%-100%,“未来三五年国内外必定出现一大堆GPU架构之外的AI芯片”。

星星点点,足以让英伟达这个巨物被撼动。

“你以为英伟达就像是外表看来一骑绝尘无对手?真不是”,一位英伟达员工告诉36氪。正如黄仁勋经常挂在嘴边的一句话,“我们距离倒闭,只有30天的时间 ”。

英伟达做了十几年的准备,再撞上OpenAI这样的天才公司,才共同催化才出现了英伟达的奇迹。在过去,半导体行业最不缺乏弯道超车巨头的故事。

围剿英伟达之战的硝烟,早已燃起。

end

end